- Ентропія (від грец. Ἐντροπία «поворот», «перетворення») - широко використовуваний в природних і точних науках термін. Вперше введено в рамках термодинаміки як функція стану термодинамічної системи, яка визначає міру незворотного розсіювання енергії. У статистичній фізиці ентропія характеризує ймовірність здійснення будь-якого макроскопічного стану. Крім фізики, термін широко вживається в математиці: теорії інформації і математичній статистиці.

Ентропія може інтерпретуватися як міра невизначеності (невпорядкованості) деякої системи, наприклад, будь-якого досвіду (випробування), який може мати різні наслідки, а значить, і кількість інформації. Таким чином, другий інтерпретацією ентропії є інформаційна ємність системи. З даної інтерпретацією пов'язаний той факт, що творець поняття ентропії в теорії інформації (Клод Шеннон) спочатку хотів назвати цю величину інформацією.

Поняття інформаційної ентропії застосовується як в теорії інформації і математичній статистиці, так і в статистичній фізиці (ентропія Гіббса і її спрощений варіант - ентропія Больцмана). Математичний зміст інформаційної ентропії - це логарифм числа доступних станів системи (підстава логарифма може бути різним, воно визначає одиницю виміру ентропії). Така функція від числа станів забезпечує властивість адитивності ентропії для незалежних систем. Причому, якщо стану розрізняються за ступенем доступності (т. Е. Різновірогідні), під числом станів системи потрібно розуміти їх ефективне кількість, яке визначається наступним чином. Нехай стану системи різновірогідні і мають ймовірність

(\\ Displaystyle p)

Тоді число станів

(\\ Displaystyle N \u003d 1 / p)

(\\ Displaystyle \\ log N \u003d \\ log (1 / p))

У разі різних ймовірностей станів

(\\ Displaystyle p_ (i))

Розглянемо середньозважену величину

(\\ Displaystyle \\ log (\\ overline (N)) \u003d \\ sum _ (i \u003d 1) ^ (N) p_ (i) \\ log (1 / p_ (i)))

(\\ Displaystyle (\\ overline (N)))

Ефективна кількість станів. З даної інтерпретації безпосередньо випливає вираз для інформаційної ентропії Шеннона

(\\ Displaystyle H \u003d \\ log (\\ overline (N)) \u003d - \\ sum _ (i \u003d 1) ^ (N) p_ (i) \\ log p_ (i))

Подібна інтерпретація справедлива і для ентропії Рен `ї, яка є одним з узагальнень поняття інформаційна ентропія, але в цьому випадку інакше визначається ефективна кількість станів системи (можна показати, що ентропії Рен` ї відповідає ефективна кількість станів, яке визначається як середнє статечне зважене з параметром

(\\ Displaystyle q \\ leq 1)

Ентропія (від грец. Ἐντροπία «поворот», «перетворення») - широко використовуваний в природних і точних науках термін. Вперше введено в рамках термодинаміки як функція стану термодинамічної системи, яка визначає міру незворотного розсіювання енергії. У статистичній фізиці ентропія характеризує ймовірність здійснення будь-якого макроскопічного стану. Крім фізики, термін широко вживається в математиці: теорії інформації і математичній статистиці.

У науку це поняття ввійшло ще в XIX столітті. Спочатку воно було застосовано до теорії теплових машин, але досить швидко з'явилося і в інших областях фізики, особливо, в теорії випромінювання. Дуже скоро ентропія стала застосовуватися в космології, біології, в теорії інформації. Різні галузі знань виділяють різні види заходів хаосу:

- інформаційна;

- термодинамічна;

- диференціальна;

- культурна та ін.

Наприклад, для молекулярних систем існує ентропія Больцмана, яка визначає міру їх хаотичності та однорідності. Больцман зумів встановити взаємозв'язок між заходом хаосу і ймовірністю стану. Для термодинаміки дане поняття вважається мірою незворотного розсіювання енергії. Це функція стану термодинамічної системи. У відокремленої системі ентропія зростає до максимальних значень, і вони в підсумку стають станом рівноваги. Ентропія інформаційна увазі деяку міру невизначеності або непередбачуваності.

Ентропія може інтерпретуватися як міра невизначеності (невпорядкованості) деякої системи, наприклад, будь-якого досвіду (випробування), який може мати різні наслідки, а значить, і кількість інформації. Таким чином, другий інтерпретацією ентропії є інформаційна ємність системи. З даної інтерпретацією пов'язаний той факт, що творець поняття ентропії в теорії інформації (Клод Шеннон) спочатку хотів назвати цю величину інформацією.

Для оборотних (рівноважних) процесів виконується наступне математичне рівність (наслідок так званого рівності Клаузіуса), де - підведена теплота, - температура, і - стану, і - ентропія, що відповідає цим станам (тут розглядається процес переходу зі стану в стан).

Для необоротних процесів виконується нерівність, що випливає з так званого нерівності Клаузіуса, де - підведена теплота, - температура, і - стану, і - ентропія, що відповідає цим станам.

Тому ентропія адіабатично ізольованої (немає підведення або відведення тепла) системи при незворотних процесах може тільки зростати.

Використовуючи поняття ентропії Клаузіус (1876) дав найбільш загальне формулювання 2-го початку термодинаміки: при реальних (необоротних) адіабатичних процесах ентропія зростає, досягаючи максимального значення в стані рівноваги (2-е початок термодинаміки не є абсолютним, воно порушується при флуктуаціях).

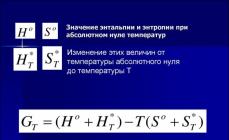

Абсолютна ентропія (S) речовини або процесу - це зміна доступної енергії при теплопередачі при даній температурі (Btu / R, Дж / К). Математично ентропія дорівнює теплопередачі, поділеній на абсолютну температуру, при якій відбувається процес. Отже, процеси передачі великої кількості теплоти більше збільшують ентропію. Також зміни ентропії збільшаться при передачі теплоти при низькій температурі. Так як абсолютна ентропія стосується придатності всієї енергії всесвіту, температуру зазвичай вимірюють в абсолютних одиницях (R, К).

питому ентропію (S) вимірюють щодо одиниці маси речовини. Температурні одиниці, які використовуються при обчисленні різниць ентропії станів, часто наводяться з температурними одиницями в градусах за Фаренгейтом або Цельсієм. Так як відмінності в градусах між шкалами Фаренгейта і Ренкина або Цельсія і Кельвіна рівні, рішення в таких рівняннях буде правильним незалежно від того, виражена ентропія в абсолютних або звичайних одиницях. У ентропії така ж дана температура, як і дана ентальпія певної речовини.

Підводимо підсумок: ентропія збільшується, отже, будь-якими своїми діями ми збільшуємо хаос.

Просто про складне

Ентропія - міра безладу (і характеристика стану). Візуально, ніж більш рівномірно розташовані речі в деякому просторі, тим більше ентропія. Якщо цукор лежить в склянці чаю у вигляді шматочка, ентропія цього стану мала, якщо розчинився і розподілився по всьому об'єму - велика. Безлад можна виміряти, наприклад, вважаючи скількома способами можна розкласти предмети в заданому просторі (ентропія тоді пропорційна логарифму числа розкладок). Якщо все шкарпетки складені гранично компактно однієї стопкою на полиці в шафі, число варіантів розкладки мало і зводиться лише до числа перестановок шкарпеток в стосі. Якщо шкарпетки можуть перебувати в довільному місці в кімнаті, то існує немислиме число способів розкласти їх, і ці розкладки не повторюються протягом нашого життя, як і форми сніжинок. Ентропія стану «шкарпетки розкидані» - величезна.

Другий закон термодинаміки говорить, що мимовільно в замкнутій системі ентропія не може зменшуватися (зазвичай вона зростає). Під її впливом розсіюється дим, розчиняється цукор, розсипаються згодом камені і шкарпетки. Ця тенденція пояснюється просто: речі рухаються (переміщаються нами або силами природи) зазвичай під впливом випадкових імпульсів, які не мають спільної мети. Якщо імпульси випадкові, все буде рухатися від порядку до безладу, тому що способів досягнення безладу завжди більше. Уявіть собі шахову дошку: король може вийти з кута трьома способами, всі можливі для нього шляхи ведуть з кута, а прийти назад в кут з кожної сусідньої клітини - тільки одним способом, причому цей хід буде тільки одним з 5 або з 8 можливих ходів. Якщо позбавити його цілі і дозволити рухатися випадково, він врешті-решт з однаковою ймовірністю зможе виявитися в будь-якому місці шахівниці, ентропія стане вище.

У газі або рідини роль такої разупорядочівающей сили грає теплове рух, у вашій кімнаті - ваші миттєві бажання піти туди, сюди, повалятися, попрацювати, ітд. Які ці бажання - неважливо, головне, що вони не пов'язані з прибиранням і не пов'язані один з одним. Щоб знизити ентропію, потрібно піддати систему зовнішнього впливу і зробити над нею роботу. Наприклад, згідно з другим законом, ентропія в кімнаті буде безперервно зростати, поки не зайде мама і не попросить вас злегка прибрати. Необхідність зробити роботу означає також, що будь-яка система буде опиратися зменшення ентропії і наведення порядку. У Всесвіті та ж історія - ентропія як почала зростати з Великого Вибуху, так і буде рости, поки не прийде Мама.

Міра хаосу у Всесвіті

Для Всесвіту не може бути застосований класичний варіант обчислення ентропії, тому що в ній активні гравітаційні сили, а речовина саме по собі не може утворити замкнуту систему. Фактично, для Всесвіту - це міра хаосу.

Найголовнішим і найбільшим джерелом невпорядкованості, яка спостерігається в нашому світі, вважаються всім відомі масивні освіти - чорні діри, масивні і надмасивні.

Спроби точно розрахувати значення заходи хаосу поки не можна назвати вдалими, хоча вони відбуваються постійно. Але все оцінки ентропії Всесвіту мають значний розкид в отриманих значеннях - від одного до трьох порядків. Це пояснюється не тільки недоліком знань. Відчувається недостатність відомостей про вплив на розрахунки не тільки всіх відомих небесних об'єктів, а й темної енергії. Вивчення її властивостей і особливостей поки в зародку, а вплив може бути визначальним. Міра хаосу Всесвіту весь час змінюється. Вчені постійно проводять певні дослідження, щоб отримати можливість визначення загальних закономірностей. Тоді буде можна робити досить вірні прогнози існування різних космічних об'єктів.

Теплова смерть Всесвіту

У будь-якої замкнутої термодинамічної системи є кінцевий стан. Всесвіт теж не є винятком. Коли припиниться спрямований обмін всіх видів енергій, вони переродятся в теплову енергію. Система перейде в стан теплової смерті, якщо термодинамічна ентропія отримає найвищі значення. Висновок про такий кінці нашого світу сформулював Р.Клаузиус в 1865 році. Він взяв за основу другий закон термодинаміки. Згідно з цим законом, система, яка не обмінюється енергіями з іншими системами, буде шукати рівноважний стан. А воно цілком може мати параметри, характерні для теплової смерті Всесвіту. Але Клаузиус не брав до уваги впливу гравітації. Тобто, для Всесвіту, на відміну від системи ідеального газу, де частки розподілені в якомусь обсязі рівномірно, однорідність часток не може відповідати найбільшому значенню ентропії. І все-таки, до кінця не ясно, ентропія - допустима міра хаосу або смерть Всесвіту?

Ентропія в нашому житті

У піку другому початку термодинаміки, згідно з положеннями якого все повинно розвиватися від складного до простого, розвиток земної еволюції просувається в зворотному напрямку. Ця нестиковка обумовлена \u200b\u200bтермодинаміки процесів, які мають незворотній характер. Споживання живим організмом, якщо його представити як відкриту термодинамічну систему, відбувається в менших обсягах, ніж викидається з неї.

Харчові речовини мають меншою ентропією, ніж вироблені з них продукти виділення. Тобто, організм живий, тому що може викинути цей захід хаосу, яка в ньому виробляється в силу протікання незворотних процесів. Наприклад, шляхом випаровування з організму виводиться близько 170 г води, тобто тіло людини компенсує зниження ентропії деякими хімічними і фізичними процесами.

Ентропія - це якась міра вільного стану системи. Вона тим повніше, ніж менші обмеження ця система має, але за умови, що ступенів свободи у неї багато. Виходить, що нульове значення заходи хаосу - це повна інформація, а максимальне - абсолютне незнання.

Все наше життя - суцільна ентропія, тому що міра хаосу іноді перевищує міру здорового глузду. Можливо, не так далеко час, коли ми прийдемо до другого закону термодинаміки, адже іноді здається, що розвиток деяких людей, так і цілих держав, вже пішло назад, тобто, від складного до примітивного.

висновки

Ентропія - позначення функції стану фізичної системи, збільшення якої здійснюється за рахунок реверсивної (оборотної) подачі тепла в систему;

величина внутрішньої енергії, яка не може бути перетворена в механічну роботу;

точне визначення ентропії проводиться за допомогою математичних розрахунків, за допомогою яких встановлюється для кожної системи відповідний параметр стану (термодинамічне властивість) пов'язаної енергії. Найвиразніше ентропія проявляється в термодинамічних процесах, де розрізняють процеси, оборотні і необоротні, причому в першому випадку ентропія залишається незмінною, а в другому постійно росте, і це збільшення здійснюється за рахунок зменшення механічної енергії.

Отже, все те безліч необоротних процесів, які відбуваються в природі, супроводжується зменшенням механічної енергії, що в кінцевому підсумку повинно привести до зупинки, до «теплової смерті». Але цього не може статися, оскільки з точки зору космології неможливо до кінця завершити емпіричне пізнання всієї «цілісності Всесвіту», на основі якого наше уявлення про ентропії могло б знайти обґрунтоване застосування. Християнські теологи вважають, що, грунтуючись на ентропії, можна зробити висновок про кінець світу і використовувати її для доказу «існування Бога». У кібернетиці слово «ентропія» використовується в сенсі, відмінному від його прямого значення, який лише формально можна вивести з класичного поняття; воно означає: середню наповненість інформацією; ненадійність щодо цінності «очікування» інформації.

Див. також «Фізичний портал» Ентропія може інтерпретуватися як міра невизначеності (невпорядкованості) деякої системи, наприклад, будь-якого досвіду (випробування), який може мати різні наслідки, а значить, і кількість інформації. Таким чином, другий інтерпретацією ентропії є інформаційна ємність системи. З даної інтерпретацією пов'язаний той факт, що творець поняття ентропії в теорії інформації (Клод Шеннон) спочатку хотів назвати цю величину інформацією.

H \u003d log \u2061 N ¯ \u003d - Σ i \u003d 1 N p i log \u2061 p i. (\\ Displaystyle H \u003d \\ log (\\ overline (N)) \u003d - \\ sum _ (i \u003d 1) ^ (N) p_ (i) \\ log p_ (i).)Подібна інтерпретація справедлива і для ентропії Рен `ї, яка є одним з узагальнень поняття інформаційна ентропія, але в цьому випадку інакше визначається ефективна кількість станів системи (можна показати, що ентропії Рен` ї відповідає ефективна кількість станів, яке визначається як середнє статечне зважене з параметром q ≤ 1 (\\ displaystyle q \\ leq 1) від величин 1 / p i (\\ displaystyle 1 / p_ (i))) .

Слід зауважити, що інтерпретація формули Шеннона на основі зваженого середнього перестав бути її обґрунтуванням. Строгий висновок цієї формули можна отримати з комбінаторних міркувань за допомогою асимптотичної формули Стірлінга і полягає в тому, що комбинаторность розподілу (тобто число способів, якими воно може бути реалізовано) після взяття логарифма і нормування в межі збігається з виразом для ентропії у вигляді, запропонованому Шенноном.

У широкому сенсі, в якому слово часто вживається в побуті, ентропія означає міру невпорядкованості або хаотичності системи: чим менше елементи системи підпорядковані якомусь порядку, тим вище ентропія.

1 . Нехай деяка система може перебувати в кожному з N (\\ displaystyle N) доступних станів з ймовірністю p i (\\ displaystyle p_ (i)), де i \u003d 1,. . . , N (\\ displaystyle i \u003d 1, ..., N). ентропія H (\\ displaystyle H) є функцією тільки ймовірностей P \u003d (p 1,..., P N) (\\ displaystyle P \u003d (p_ (1), ..., p_ (N))): H \u003d H (P) (\\ displaystyle H \u003d H (P)). 2 . Для будь-якої системи P (\\ displaystyle P) справедливо H (P) ≤ H (P u n i f) (\\ displaystyle H (P) \\ leq H (P_ (unif))), де P u n i f (\\ displaystyle P_ (unif)) - система з рівномірним розподілом ймовірностей: p 1 \u003d p 2 \u003d. . . \u003d P N \u003d 1 / N (\\ displaystyle p_ (1) \u003d p_ (2) \u003d ... \u003d p_ (N) \u003d 1 / N). 3 . Якщо додати в систему стан p N + 1 \u003d 0 (\\ displaystyle p_ (N + 1) \u003d 0), То ентропія системи не зміниться. 4 . Ентропія сукупності двох систем P (\\ displaystyle P) і Q (\\ displaystyle Q) має вид H (P Q) \u003d H (P) + H (Q / P) (\\ displaystyle H (PQ) \u003d H (P) + H (Q / P)), де H (Q / P) (\\ displaystyle H (Q / P)) - середня по ансамблю P (\\ displaystyle P) умовна ентропія Q (\\ displaystyle Q).Зазначений набір аксіом однозначно призводить до формули для ентропії Шеннона.

Вживання в різних дисциплінах

- Термодинамічна ентропія - термодинамічна функція, що характеризує міру незворотною дисипації енергії в ній.

- У статистичній фізиці - характеризує ймовірність здійснення деякого макроскопічного стану системи.

- У математичній статистиці - міра невизначеності розподілу ймовірностей.

- Інформаційна ентропія - в теорії інформації міра невизначеності джерела повідомлень, що визначається ймовірності появи тих чи інших символів при їх передачі.

- Ентропія динамічної системи - в теорії динамічних систем міра хаотичності в поведінці траєкторій системи.

- Диференціальна ентропія - формальне узагальнення поняття ентропії для безперервних розподілів.

- Ентропія відображення - частина інформації про дискретній системі, який не відтворюється при відображенні системи через сукупність своїх частин.

- Ентропія в теорії управління - міра невизначеності стану або поведінки системи в даних умовах.

У термодинаміки

Поняття ентропії вперше було введено Клаузиусом в термодинаміки в 1865 році для визначення міри незворотного розсіювання енергії, заходи відхилення реального процесу від ідеального. Певна як сума наведених теплот, вона є функцією стану і залишається постійною при замкнутих оборотних процесах, тоді як в необоротних - її зміна завжди позитивно.

Математично ентропія визначається як функція стану системи, певна з точністю до довільної сталої. Різниця ентропій в двох рівноважних станах 1 і 2, за визначенням, дорівнює наведеним кількості тепла ( δ Q / T (\\ displaystyle \\ delta Q / T)), Яке треба повідомити системі, щоб перевести її зі стану 1 в стан 2 по будь-якому квазістатична шляху:

Δ S 1 → 2 \u003d S 2 - S 1 \u003d ∫ 1 → 2 δ QT (\\ displaystyle \\ Delta S_ (1 \\ to 2) \u003d S_ (2) -S_ (1) \u003d \\ int \\ limits _ (1 \\ to 2) (\\ frac (\\ delta Q) (T))). (1) Так як ентропія визначена з точністю до довільної сталої, то можна умовно прийняти стан 1 за початкове і покласти S 1 \u003d 0 (\\ displaystyle S_ (1) \u003d 0). тоді

S \u003d ∫ δ Q T (\\ displaystyle S \u003d \\ int (\\ frac (\\ delta Q) (T))), (2.) Тут інтеграл береться для довільного квазістатичного процесу. диференціал функції S (\\ displaystyle S) має вид

d S \u003d δ Q T (\\ displaystyle dS \u003d (\\ frac (\\ delta Q) (T))). (3) Ентропія встановлює зв'язок між макро- і мікро- станами. Особливість даної характеристики полягає в тому, що це єдина функція у фізиці, яка показує спрямованість процесів. Оскільки ентропія є функцією стану, то вона не залежить від того, як здійснений перехід з одного стану системи в інше, а визначається тільки початковим і кінцевим станами системи.

ЕНТРОПІЯ

ЕНТРОПІЯ

(Від грец. Entropia - поворот,)

частина внутрішньої енергії замкнутої системи або енергетичної сукупності Всесвіту, яка не може бути використана, зокрема не може перейти або бути перетворена в механічну роботу. Точне ентропії проводиться за допомогою математичних розрахунків. Найвиразніше ефект ентропії видно на прикладі термодинамічних процесів. Так, ніколи повністю не переходить в механічну роботу, перетворюючись в ін. Види енергії. Примітно, що при оборотних процесах величина ентропії залишається незмінною, при незворотних, навпаки, неухильно зростає, причому цей приріст відбувається за рахунок зменшення механічної енергії. Отже, все те незворотних процесів, які відбуваються в природі, супроводжується зменшенням механічної енергії, що в кінцевому підсумку повинно привести до загального паралічу, або, інакше кажучи, «теплової смерті». Але такий правомочний лише в разі постулирования тоталітарності Всесвіту як замкнутої емпіричної даності. Христ. теологи, грунтуючись на ентропії, говорили про кінець світу, використовуючи її як існування Бога.

Філософський енциклопедичний словник. 2010 .

ЕНТРОПІЯ

(Грец. Ἐντροπία - поворот, перетворення) - стану термодинамич. системи, що характеризує напрямок протікання самовільних процесів в цій системі і є мірою їх незворотності. Поняття Е. введено в 1865 Р. Клаузиусом для характеристики процесів перетворення енергії; в 1877 Л.Больцман дав йому статистич. тлумачення. За допомогою поняття Е. формулюється другий закон термодинаміки: Е. термоізольованому системи завжди тільки збільшується, тобто така, надана сама собі, прагне до теплового рівноваги, при к-ром Е. максимальна. У статистич. фізики Е. виражає невизначеність мікроскопіч. стану системи: чим більше мікроскопіч. станів системи відповідають даним макроскопіч. станом, тим вище термодинамич. і Е. останнього. Система з малоймовірною структурою, надана сама собі, розвивається в бік найбільш імовірною структури, тобто в бік зростання Е. Це, однак, відноситься тільки до замкнутим системам, тому Е. не може бути використана для обґрунтування теплової смерті всесвіту. У теорії і н ф о р м а ц і й Е. розглядається як брак інформації в системі. У кібернетиці за допомогою понять Е. і негентропії (отрицат. Ентропії) висловлюють міру організованості системи. Будучи справедливою стосовно до систем, що підкоряється статистич. закономірностям, цей захід, проте, вимагає великої обережності при перенесенні на біологічні, мовні та соціальні системи.

Літ .: Шамбадаль П., Розвиток і додатки поняття Е., [пер. с.], М., 1967; Пірс Дж., Символи, сигнали, шуми, [пер. з англ.], М., 1967.

Л. Фаткин. Москва.

Філософська енциклопедія. У 5-х т. - М .: Радянська енциклопедія. За редакцією Ф. В. Константинова. 1960-1970 .

Синоніми:Дивитися що таке "ЕНТРОПІЯ" в інших словниках:

- (від грец. Entropia поворот, перетворення), поняття, вперше введене в термодинаміці для визначення міри незворотного розсіювання енергії. Е. широко застосовується і в ін. Галузях науки: у статистичній фізиці як міра ймовірності здійснення к. ... ... фізична енциклопедія

ЕНТРОПІЯ, показник випадковості або невпорядкованості будови фізичної системи. У термодинаміки ентропія виражає кількість теплової енергії, придатної для здійснення роботи: чим енергії менше, тим вище ентропія. У масштабах Всесвіту ... ... Науково-технічний енциклопедичний словник

Міра внутрішньої невпорядкованості інформаційної системи. Ентропія збільшується при хаотичному розподілі інформаційних ресурсів і зменшується при їх впорядкування. За англійськи: Entropy Див. Також: Інформація Фінансовий словник Фінам ... Фінансовий словник

- [англ. entropy Словник іншомовних слів російської мови

ентропія - Ентропія ♦ Entropie Властивість стану ізольованої (або прийнятої за таку) фізичної системи, що характеризується кількістю мимовільного зміни, на яке вона здатна. Ентропія системи досягає максимуму, коли вона повністю ... Філософський словник Спонвіль

- (від грец. Entropia поворот перетворення) (зазвичай позначається S), функція стану термодинамічної системи, зміна якої dS в рівноважному процесі дорівнює відношенню кількості теплоти dQ, повідомленого системі або відведеного від неї, до ... ... Великий Енциклопедичний словник

Безлад, розлад Словник російських синонімів. ентропія ім., кол під синонімів: 2 безлад (127) ... Словник синонімів

ЕНТРОПІЯ - (від грец. En в, всередину і trope поворот, перетворення), величина, що характеризує міру пов'язаної енергії (D S), яка в ізотермічному процесі не може бути перетворена в роботу. Вона визначається логарифмом термодинамічної ймовірності і ... ... Екологічний словник

ентропія - і, ж. entropie f., нім. Entropie гр. en в, всередину + trope поворот, перетворення. 1. Фізична величина, що характеризує тепловий стан тіла або системи тіл і можливі зміни цих станів. Обчислення ентропії. БАС 1. || ... ... Історичний словник галліцізмов російської мови

ЕНТРОПІЯ - ЕНТРОПІЯ, поняття, що вводиться в термодинаміки і є як би мірою незворотності процесу, мірою переходу енергії в таку форму, з к рій вона не може мимовільно перейти в інші форми. Всі мислимі процеси, що протікають в будь-якій системі, ... ... Велика медична енциклопедія

книги

- Статистична механіка. Ентропія, параметри порядку, теорія складності, Джеймс П. сіткових. Підручник "Статистична механіка: ентропія, параметри порядку і складність", написаний професором Корнельського університету (США) Джеймсом сіткових і був вперше виданий англійською мовою в 2006 ...

Ентропія - величина, яка характеризує ступінь невпорядкованості, а також тепловий стан Всесвіту. Греки визначили це поняття як перетворення або переворот. Але в астрономії та фізики його значення дещо відмінне. Говорячи простою мовою, ентропія - це міра хаосу.

види

У науку це поняття ввійшло ще в XIX столітті. Спочатку воно було застосовано до теорії теплових машин, але досить швидко з'явилося і в інших областях фізики, особливо, в теорії випромінювання. Дуже скоро ентропія стала застосовуватися в космології, біології, в теорії інформації. Різні галузі знань виділяють різні види заходів хаосу:

- інформаційна

- термодинамічна

- диференціальна

- культурна

Наприклад, для молекулярних систем існує ентропія Больцмана, яка визначає міру їх хаотичності та однорідності. Больцман зумів встановити взаємозв'язок між заходом хаосу і ймовірністю стану. Для термодинаміки дане поняття вважається мірою незворотного розсіювання енергії. Це функція стану термодинамічної системи.

У відокремленої системі ентропія зростає до максимальних значень, і вони в підсумку стають станом рівноваги.

Ентропія інформаційна увазі деяку міру невизначеності або непередбачуваності.

ентропія Всесвіту

Для Всесвіту не може бути застосований класичний варіант обчислення ентропії, тому що в ній активні гравітаційні сили, а речовина саме по собі не може утворити замкнуту систему. Фактично, для Всесвіту - це міра хаоса.Попиткі точно розрахувати значення заходи хаосу поки не можна назвати вдалими, хоча вони відбуваються постійно. Але все оцінки ентропії Всесвіту мають значний розкид в отриманих значеннях - від одного до трьох порядків. Це пояснюється не тільки недоліком знань. Відчувається недостатність відомостей про вплив на розрахунки не тільки всіх відомих небесних об'єктів, а й темної енергії. Вивчення її властивостей і особливостей поки в зародку, а вплив може бути визначальним. Міра хаосу Всесвіту весь час змінюється.

Теплова смерть Всесвіту

У будь-якої замкнутої термодинамічної системи є кінцевий стан.Всесвіт теж не є винятком. Коли припиниться спрямований обмін всіх видів енергій, вони переродятся в теплову енергію. Система перейде в стан теплової смерті, якщо термодинамічна ентропія отримає найвищі значення. Висновок про такий кінці нашого світу сформулював Р.Клаузиус в 1865 році. Він взяв за основу другий закон термодинаміки. Згідно з цим законом, система, яка не обмінюється енергіями з іншими системами, буде шукати рівноважний стан. А воно цілком може мати параметри, характерні для теплової смерті Всесвіту. Але Клаузиус не брав до уваги впливу гравітації. Тобто, для Всесвіту, на відміну від системи ідеального газу, де частки розподілені в якомусь обсязі рівномірно, однорідність часток не може відповідати найбільшому значенню ентропії. І все-таки, до кінця не ясно, ентропія - допустима міра хаосу або смерть Всесвіту?

У нашому житті

У піку другому початку термодинаміки, згідно з положеннями якого все повинно розвиватися від складного до простого, розвиток земної еволюції просувається в зворотному напрямку. Ця нестиковка обумовлена \u200b\u200bтермодинаміки процесів, які мають незворотній характер. Споживання живим організмом, якщо його представити як відкриту термодинамічну систему, відбувається в менших обсягах, ніж викидається з неї.

Харчові речовини мають меншою ентропією, ніж вироблені з них продукти виділення.

Тобто, організм живий, тому що може викинути цей захід хаосу, яка в ньому виробляється в силу протікання незворотних процесів. Наприклад, шляхом випаровування з організму виводиться близько 170 г води, тобто тіло людини компенсує зниження ентропії деякими хімічними і фізичними процесами.

Ентропія - це якась міра вільного стану системи. Вона тим повніше, ніж менші обмеження ця система має, але за умови, що ступенів свободи у неї багато. Виходить, що нульове значення заходи хаосу - це повна інформація, а максимальне - абсолютне незнання.

Все наше життя - суцільна ентропія, тому що міра хаосу іноді перевищує міру здорового глузду. Можливо, не так далеко час, коли ми прийдемо до другого закону термодинаміки, адже іноді здається, що розвиток деяких людей, так і цілих держав, вже пішло назад, тобто, від складного до примітивного.